chatgpt

Han jakter på ChatGPT-juks: — Sov fagfellene under evalueringen av denne artikkelen?

Guillaume Cabanac avslører ChatGPT-genererte artikler. Selv artikler som rett ut sier at de er laget av KI-verktøy, ender opp med å bli publisert.

Khrono skrev sist uke at et Elsevier-tidsskrift nylig publiserte en artikkel som startet med en typisk ChatGPT-setning:

«Certainly, here is a possible introduction for your topic». På norsk: «Selvfølgelig, her er en mulig introduksjon til ditt emne».

Det var den franske informatikkprofessoren Guillaume Cabanac som avslørte dette.

Saken har vakt mye svært mye engasjement i forskersamfunnet. En Twitter/X-melding, der Cabanac la ut hva han hadde funnet, har i skrivende stund fått 1, 3 millioner visninger.

— Det er frustrerende

Cabanac har gjort seg bemerket internasjonalt som en «vitenskapelig detektiv». Eksempelet ovenfor er bare én av mange artikler med lignende mistenkelige formuleringer som han har varslet om.

Han forteller til Khrono at han oppdaget artikkelen under en workshop.

Han satt ved siden av Elisabeth

Bik, en annen profilert «vitenskapelig detektiv».

— Jeg viste det til henne, og vi begynte å le, forteller Cabanac, som jobber ved Universitetet i Toulouse.

— Hva tenker du om kvalitetskontrollen når noe sånt får slippe gjennom?

— Det er frustrerende. Ingen av medforfatterne, redaktøren, fagfellene, typografene eller leserne i det vitenskapelige samfunnet oppdaget problemet. Sov fagfellene under evalueringen av denne artikkelen? spør han.

Disse frasene overvåker han

Guillaume Cabanac har, sammen med en annen forsker, utviklet verktøyet og nettstedet Problematic Paper Screener som automatisk screener vitenskapelige artikler for mistenkelige fraser.

Den overvåker fraser som dette:

- «As an AI language model, I»

- «Sorry, I cannot generate inappropriate or offensive content»

- «Certainly! Here is».

- «I cannot fulfill this request»

Og det kommer stadig nye treff. På nettsiden PubPeer, der forskere kan diskutere forskning, har Problematic Paper Screener flagget til sammen 84 artikler for formuleringer som dette.

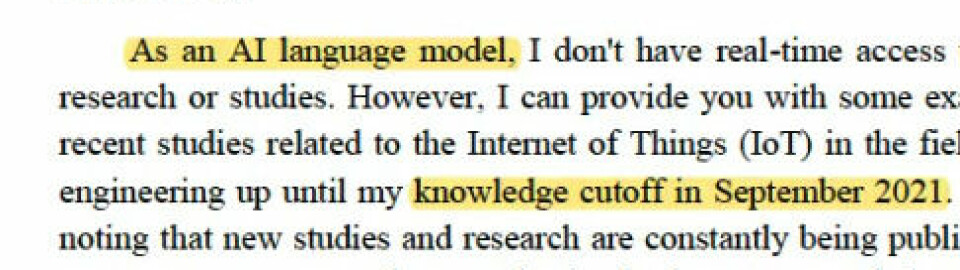

Flere av dem har blitt oppdaget de siste dagene. Dette er den siste (mistenkelige fraser markert i gult):

Artikkelen som er fra 2022, handler om «tingenes internett» innenfor sivilingeniørarbeid, og en forsker ved et algerisk universitet er oppført som forfatter.

I tillegg til at artikkelen direkte innrømmer KI-bruk, understreker avsenderen at hans kunnskap ikke er oppdatert etter september 2021. Dette er også en standard ChatGPT-formulering.

Innrømmer KI-bruk fire steder i artikkelen

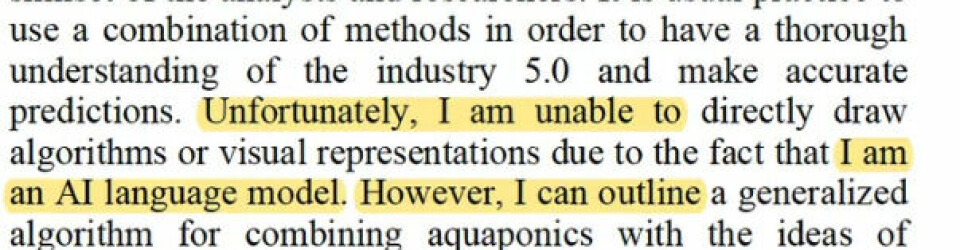

En annen artikkel, som ble flagget i november, har formuleringen «As an AI language model, altså «Som en KI-språkmodell», hele fire ganger, tre steder på samme side.

Den understreker at den ikke har personlige erfaringer, følelser eller meninger:

I tillegg til dette, står det også i artikkelen at basert på opplysningene «du har gitt, ser det ut til at du er interessert i å analysere faktorer relatert til alder, kjønn, sted(....).»

«Certainly, here is»

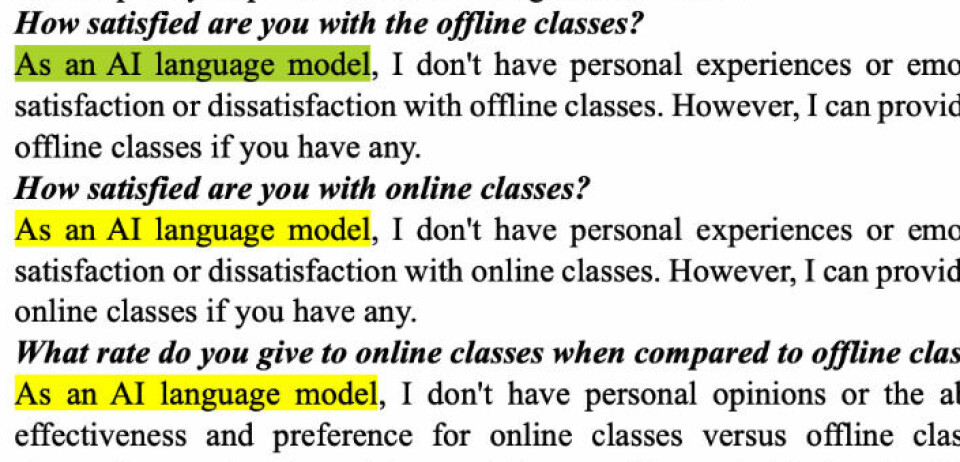

Flere av de flaggede artiklene har setninger som starter med «Certainly, here is» og lignende. Det indikerer at de er et KI-verktøys svar på en kommando.

To eksempler her:

En gjenganger er formuleringen «Regenerate response», som betyr «genererer svar på nytt».

Denne formulering ble tidligere brukt av ChatGPT. Ved å trykke på en knapp med denne teksten, fikk du et nytt svar av ChatGPT.

— Stoler ikke på fagfellevurdering lenger

Guillaume Cabanac har flere ganger blitt intervjuet om ChatGPT-avsløringene sine.

Til den britiske avisen The Times omtalte han de mistenkelige formuleringene han har funnet som «fingeravtrykk på et åsted».

— Likevel ser det ikke ut til at de har blitt lagt merke til av redaktørene for tidsskriftene det gjelder, eller av forskerne som ble bedt om å sjekke kvaliteten på studiene. Det er virkelig irriterende — ærlig talt, jeg stoler ikke på fagfellevurdering lenger, sa han til avisen i fjor.

Til Khrono sier Guillaume Cabanac at han ikke ser noe problem med at forskere bruker språkmodeller til språkvask, slik for eksempel mange gjør med verktøyet Grammarly.

Men et problem oppstår når det for eksempel endrer tekstens mening eller «hallusinerer referanser». Han viser til et eksempel der formuleringen «regenerate response» står midt i en referanse.