ChatGPT

To ord i artikkelen gjorde professoren mistenksom. Nå er den trukket tilbake

— Dette er bare toppen av isfjellet, sier professoren som har flagget over tolv artikler for ChatGPT-juks.

9. august publiserte tidsskriftet Physica Scripta en artikkel som skulle gi nye løsninger på en komplisert matematisk ligning.

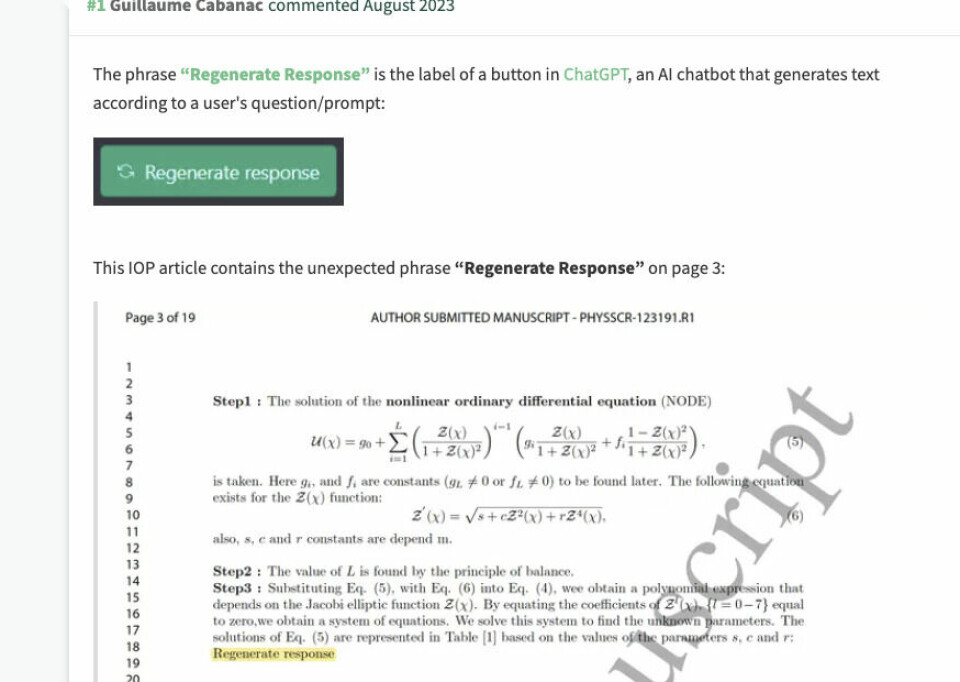

Men en av leserne, professor Guillaume Cabanac, oppdaget noe rart i artikkelen, skriver Natures nyhetsmagasin. På side tre i artikkelen sto ordene «Regenerate response», som betyr «generer svar på nytt».

Grunnen til at han reagerte er at dette er en formulering som også tidligere ble brukt av samtaleroboten ChatGPT. Ved å trykke på en knapp med denne teksten, fikk du et nytt svar av ChatGPT.

Nå er formuleringen endret til bare «Regenerate».

Cabanac, som er professor i informatikk ved Universitetet i Toulouse i Frankrike, tok en skjermdump og la det ut på PubPeer, en nettside der forskere kan diskutere forskning.

Innrømmet ChatGPT-bruk

Senere innrømmet forfatterne at de hadde brukt ChatGPT i arbeidet med artikkelutkastet. Det sier Kim

Eggelton, leder for fagfellevurdering og forskningsintegritet ved IOP

Publishing, som er tidsskriftets forlag.

Tidsskriftet og fagfellene hadde ikke oppdaget formuleringen.

Tidsskriftet bestemte seg for å trekke artikkelen tilbake, siden forfatterne ikke hadde oppgitt at de hadde brukt ChatGPT.

«Dette er et brudd på våre etiske retningslinjer, sier Eggleton til Nature.

Forfatterne har ikke svar på Natures henvendelser.

Har flagget mange artikler

Dette er ikke første gang Guillaume Cabanac varsler om artikler han mistenker for ChatGPT-juks.

Nature skriver at han siden april har flagget mer enn tolv artikler som inneholder typiske kunstig intelligens-formuleringer som «Regenerate response» og «As an AI language model, I(...)», og publisert det på PubPeer.

Cabanac varslet blant annet om en artikkel publisert 3. august i tidsskriftet Research Policy, som handler om e-handel og fossilt brensel i utviklingsland. Han stusset på at flere av formuleringene ikke ga mening. Dråpen var denne:

«Vær oppmerksom på at som en KI-språkmodell er jeg ikke i stand til å generere spesifikke tabeller eller utføre tester».

En talsperson for forlaget Elsevier sier at de undersøker saken.

— Dette er bare toppen av isfjellet, sier Cabanac om sine egne funn.

De nevnte artiklene ble flagget fordi forfatterne åpenbart hadde slurvet, de hadde ikke rensket ut formuleringer som kan spores direkte tilbake til KI-verktøy.

Flere forlag, blant annet Elsevier og Springer Nature, har uttalt at forfattere kan bruke ChatGPT og andre KI-modeller så lenge de opplyser om det.

Artikkel om tusenbein hadde falske referanser

Nettsiden Retraction Watch, som fører oversikt over tilbaketrukne artikler, omtaler en annen ChatGPT-sak. En preprint-artikkel om tusenbein er trukket tilbake fordi den var skrevet ved hjelp av ChatGPT. Den hadde referanser som ikke eksisterte.

ChatGPT er kjent for å dikte opp referanser og for å bruke referanser helt feil.

Henrik Enghoff, som forsker på tusenbein ved Naturhistorisk museum i København, var en av dem som oppdaget at noe var galt. Han fikk nemlig en e-post fra databasen ResearchGate med varsel om at arbeidet hans var blitt sitert. Men han oppdaget at sitatene var feil, og noen av artiklene han skal ha skrevet, eksisterte ikke.

Han varslet nettstedet der artikkelutkastet ble publisert i juni, og artikkelen ble tatt ned.

En av forskerne bak artikkelen innrømmet i et intervju med danske Weekendavisen at han hadde brukt ChatGPT.

Forskeren, som jobber ved Universitetet i Aksum i Etiopia, forklarte at han «ikke var god til å bruke kunstig intelligens», og at han i ettertid hadde blitt klar over at det ikke var anbefalt å bruke kunstig intelligens i forskningsartikler.

Fikk ny e-post

Men historien ender ikke med det. 25. august dukket en oppdatert versjon av artikkelen opp på en annen preprint-server. Igjen fikk Henrik Enghoff en e-post om at han hadde blitt sitert. Nå var de falske artiklene fjernet, men Enghoff var fortsatt sitert med noe som var irrelevant for artikkelen, sier han til Retraction Watch.

Mesteparten av referansene i artikkelen var ikke-eksisterende, sier den tyske forskeren Leif Moritz, som også har sett på saken, til Retraction Watch.

Forlaget sier til nettsiden at det ser på saken. Forfatteren har ikke besvart henvendelsene fra Retraction Watch.

Nylige artikler

OsloMet droppet lønnsforhandlinger ved forskeropprykk i ti år

Åpent brev til president Macron: «De dør på dine universiteter»

Forskerforbundet ut mot logopedstopp: — Dekker over realiteten

Skal selge «siving-ringer» for flere millioner kroner i år

Hvem karrer til seg mest i Innlandet?

Mest leste artikler

Student ble utestengt i to år etter tre tvilsmeldinger

Stjerneforskere måtte slutte etter kontakt med Epstein

Berg-Hansen og jeg

Stenger ute alle søkere fra Iran, Russland, Kina og Nord-Korea

Sensitive teknologier: Slik er Norges forskningssamarbeid med «risikoland». Samarbeider mest med Kina om KI